Abbiamo sempre visto l’intelligenza artificiale dentro i confini di uno schermo: testi, immagini, codice, raccomandazioni. Strumenti utili, a volte impressionanti, ma sempre reversibili. Un errore si corregge, un output sbagliato si rigenera, un prompt si riscrive. Nel 2026 questa fase sta cambiando direzione. L’AI comincia a muovere oggetti, afferrare componenti, ispezionare strutture, spostarsi in ambienti reali. Quella che viene chiamata physical AI (intelligenza artificiale applicata al mondo fisico) è la convergenza tra visione artificiale, controllo motorio, sensori avanzati e modelli addestrati su enormi quantità di dati di movimento.

La differenza rispetto al software classico è che nel mondo fisico un errore non si annulla premendo “annull”a. Un braccio robotico che afferra male un pezzo può bloccare una linea, danneggiare merce, causare infortuni. La latenza conta, l’incertezza va gestita, la responsabilità diventa legale. Questo va oltre un aggiornamento incrementale del machine learning: è un cambio di perimetro.

Dalla ricerca alla fabbrica: chi si sta muovendo

I video spettacolari di robot che saltano o ballano hanno fatto molto parlare, ma nel 2026 la discriminante è un altra: continuità operativa. Conta chi riesce a tenere un robot acceso per turni interi, con metriche verificabili.

BMW ha confermato test in ambiente produttivo con Figure 02, un robot umanoide impiegato per la movimentazione di componenti. Non è ancora una fabbrica autonoma ma il segnale che l’asticella si è spostata dall’esperimento alla ripetibilità misurabile. Boston Dynamics, con la nuova generazione di Atlas elettrico, ha reso pubblica una roadmap orientata alla commercializzazione e alla fattibilità, non più alla sola ricerca. Hyundai, da parte sua, sta costruendo governance e capacità interne per gestire flotte robotiche su scala, con inserimenti di leadership provenienti da programmi concorrenti.

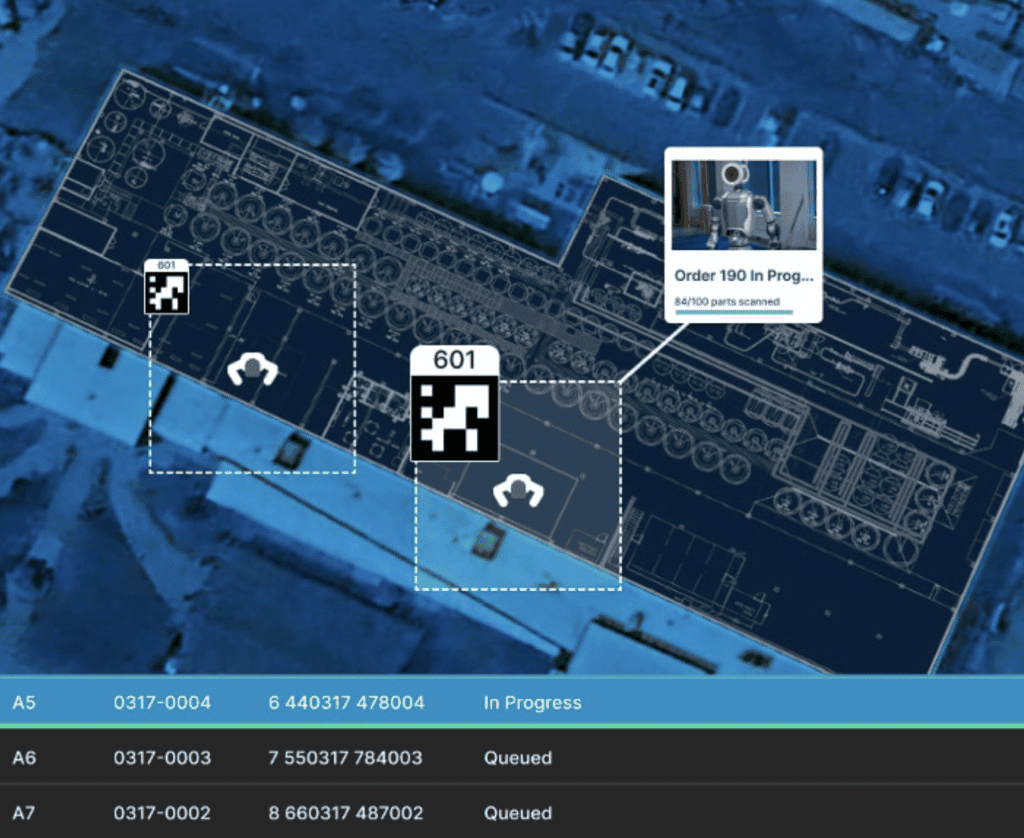

Il pattern è coerente: il 2026 sembra sempre meno l’anno del robot domestico e più quello dei robot dove l’economia regge il costo – fabbriche, magazzini, logistica, ispezione industriale. Ambienti strutturati, compiti ripetibili, ROI calcolabile.

Sul versante infrastrutturale, NVIDIA ha presentato strumenti pensati esplicitamente per la robotica: Cosmos per la generazione di dati sintetici, Isaac GR00T per il training di modelli foundation orientati al controllo motorio. L’obiettivo dichiarato è rendere la robotica più simile a un ecosistema software: standard condivisi, benchmark riproducibili, pipeline che accelerano sviluppo e test. È il tentativo di trasformare un settore ancora frammentato in una piattaforma scalabile.

I colli di bottiglia reali

Se la physical AI merita attenzione strategica è perché i suoi limiti sono concreti e non si risolvono con più GPU.

Il primo problema è la generalizzazione. Un robot utile non è quello che fa una cosa impressionante una volta, ma quello che esegue migliaia di operazioni con variazioni minime e incidenti rari. Anche le aziende leader descrivono come obiettivo critico la capacità di apprendere compiti nuovi rapidamente, senza richiedere settimane di riprogrammazione o riadattamento manuale.

Il secondo è il costo dei dati. Nel software, i dataset si raccolgono in modo relativamente pulito e scalabile. Nel mondo fisico, ogni dato costa: teleoperazione umana, setup di sensori, gestione di incidenti, variabilità ambientale. Alcune aziende stanno sperimentando world model e apprendimento da video per ridurre la dipendenza da operatori umani, ma la strada è ancora lunga e i risultati incerti.

Il terzo è sicurezza e responsabilità. Quando un agente software sbaglia, si perde tempo. Quando un robot sbaglia, può esserci un danno materiale o un infortunio. Nel 2026 cresce l’importanza di certificazioni, procedure di audit, contratti che definiscono in modo esplicito le responsabilità tra produttore, integratore e utilizzatore finale. In Europa, questo significa che la compliance diventa un moltiplicatore di costi e tempi, ma anche un filtro competitivo a favore di chi opera con standard elevati.

Cosa significa per chi decide

Per aziende e pubblica amministrazione, la physical AI nel breve periodo non sostituisce le persone: cambia dove mettere automazione e come comprarla.

Sempre più contratti tenderanno a misurare performance (uptime, throughput, tasso di incidenti) invece di acquistare “pezzi di ferro”. Il modello è quello del servizio, non del prodotto. Questo richiede una maturità diversa sia da chi vende sia da chi compra.

La simulazione diventa parte del processo decisionale. Ambienti di test e benchmark permettono di ridurre rischio e costi prima del deployment fisico. Qui le piattaforme e gli standard di valutazione contano quanto l’hardware stesso.

Sul piano competitivo, chi controlla lo stack completo (sensori, modelli, training, deployment) prova a diventare la base su cui gli altri costruiscono. È la stessa dinamica vista nel cloud computing, ma traslata su macchine e robot. La differenza è che il lock-in qui non riguarda solo i dati, ma anche la capacità fisica installata.

Il punto di verifica

Se nel 2025 bastava una demo ben fatta, nel 2026 il segnale vero sarà diverso: flotte piccole ma stabili, con metriche pubbliche o verificabili, e un ecosistema di integrazione che riduce i tempi tra acquisto e operatività.

La domanda che separa hype da realtà è semplice: quanto costa far lavorare un robot per un anno, con quante ore di fermo, e con quanta variabilità gestita in autonomia? Finché questa risposta resta opaca, la physical AI resta una promessa. Quando diventa una riga di budget prevedibile, diventa infrastruttura. E a quel punto, il gioco cambia davvero.