Con centinaia di grandi modelli di linguaggio (LLM) basati sull’Intelligenza Artificiale (IA) rilasciati, la valutazione delle prestazioni diventa sempre più critica. I benchmark testano diversi aspetti delle capacità dell’IA, dal ragionamento e la comprensione, alle abilità logiche e matematiche. Al momento, il Benchmark MMLU è il metodo più efficace per confrontare i modelli di IA.

Che cos’è il Benchmark MMLU

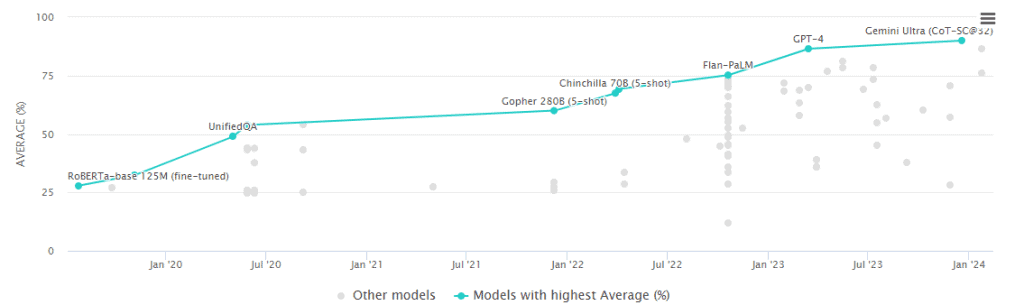

MMLU sta per Massive Multitask Language Understanding, ed è il benchmark più autorevole e utilizzato per valutare le prestazioni complessive dei grandi modelli di lingua come GPT-4, Gemini Ultra e Cloud 3. Il test include domande a scelta multipla, task di risoluzione dei problemi e domande di ragionamento che testano la capacità di un modello di elaborare informazioni complesse.

Funzionamento e struttura del test

Il Benchmark MMLU utilizza una combinazione di dataset raccolti manualmente con circa 15.000 domande. Successivamente, si fa una media delle performance del modello per categoria e si elabora punteggio finale. Alcuni esempi di materie incluse nel test sono biologia, logica e fisica. Il test è molto completo e permette una valutazione accurata delle performance dei modelli di IA.

Il dibattito sull’efficacia

Esiste un ampio dibattito sulla reale utilità di questi benchmark. Studi, tra cui quello di Google con il suo modello Gemini, evidenziano spesso un’eccellente performance su questi benchmark, ma non riflettono necessariamente l’effettiva utilità pratica del modello o la sua capacità di generare risposte dal tenore umano.

Benchmark e innovazione AI

Il MMLU non solo serve come metro di confronto per le capacità tecniche dei modelli di IA, ma stimola anche la competizione e l’innovazione nel campo. Attraverso queste valutazioni, i ricercatori possono identificare aree di miglioramento, promuovendo lo sviluppo di modelli ancora più avanzati e utili in contesti pratici.

Prestazioni intelligenza artificiale

La valutazione accurata delle prestazioni dei modelli di IA mediante il benchmark MMLU rappresenta un passo fondamentale verso la comprensione e l’ottimizzazione delle potenzialità dell’Intelligenza Artificiale. Mentre il dibattito sull’efficacia di tali test continua, l’importanza di strumenti di valutazione come il MMLU rimane indiscussa nel promuovere avanzamenti significativi nel campo dell’IA.

Leggi anche Grok, il modello di linguaggio open source di Elon Musk

Se hai gradito questo contenuto, lascia un like sui nostri social e segui il nostro sito per ulteriori contenuti sulla IA. Non dimenticare di farci sapere cosa ne pensi.