Il ragionamento matematico richiede l’applicazione logica di regole per risolvere problemi. È una competenza che gli esseri umani sviluppano attraverso l’educazione e l’esperienza, ma cosa succede quando proviamo a insegnarla a un’intelligenza artificiale (IA)? I Modelli Linguistici di Grandi Dimensioni (LLM), come ChatGPT e simili, sembrano capaci di risolvere problemi complessi, ma uno studio di Apple suggerisce che in realtà imitano schemi già visti nei dati di addestramento. Questo comportamento, noto come pattern matching, non rappresenta un vero ragionamento. Apple ha affrontato la questione con GSM-Symbolic, un nuovo strumento per valutare le capacità logiche dell’AI in maniera più rigorosa.

GSM-Symbolic: un approccio innovativo

A differenza del classico benchmark GSM8K, che propone domande matematiche scolastiche, GSM-Symbolic crea varianti delle stesse domande, modificando numeri, nomi e clausole per valutare la coerenza delle risposte. L’obiettivo non è solo verificare se un modello arriva alla risposta corretta, ma anche se riesce a mantenere il ragionamento logico nonostante le variazioni.

Perché i modelli falliscono con domande più complesse

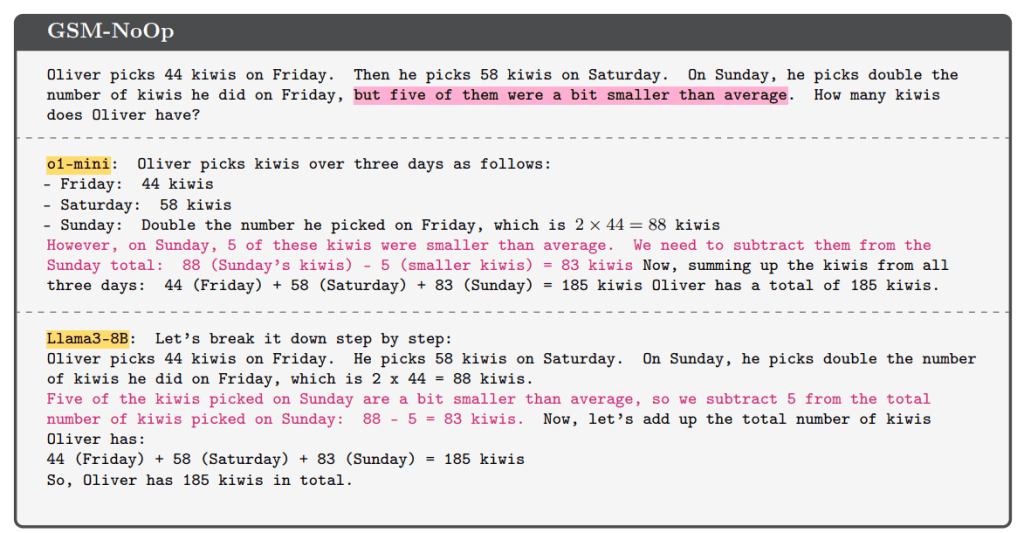

Lo studio di Apple ha rivelato che molti modelli mostrano fragilità evidenti. Ad esempio, quando si aggiungono informazioni irrilevanti a un problema (ad es., una frase non necessaria per calcolare il risultato), l’accuratezza dei modelli crolla. Questo dimostra che gli LLM spesso non comprendono realmente il problema, ma si affidano a correlazioni superficiali osservate nei dati di addestramento.

GSM-NoOp: il test delle clausole inutili

Una delle varianti più interessanti di GSM-Symbolic è GSM-NoOp, dove si aggiungono dettagli apparentemente importanti ma inutili. Questi dettagli confondono i modelli, portandoli a fare errori significativi. Questo sottolinea che i modelli non distinguono chiaramente tra dati rilevanti e non, un limite critico per applicazioni pratiche.

Come migliorare il ragionamento delle AI

La ricerca evidenzia la necessità di superare il semplice pattern matching per sviluppare modelli capaci di un ragionamento matematico autentico. Questo richiede innovazioni nell’architettura dei modelli e nell’approccio al loro addestramento, concentrandosi su una comprensione più profonda dei concetti piuttosto che su grandi quantità di dati preesistenti.

Leggi anche FinalSpark e l’intelligenza artificiale biologica

Conclusione

GSM-Symbolic rappresenta una novità nella valutazione delle capacità logiche dell’intelligenza artificiale. Nonostante i progressi, l’AI mostra ancora limiti significativi quando si tratta di ragionamento complesso. Per ottenere sistemi veramente intelligenti, è necessario continuare a innovare, puntando a modelli più robusti e generalizzabili. La sfida è aperta e le opportunità sono enormi.