C’è un punto cieco che sta diventando enorme nelle organizzazioni: il lavoro reale finisce nei prompt. Quando un dipendente apre ChatGPT o un altro assistente generativo per “fare prima”, spesso incolla contesto grezzo – email, pezzi di documenti, frammenti di codice, note delle riunione, numeri provvisori, persino tensioni tra persone. Non perché voglia esporre l’azienda, ma perché l’AI funziona meglio quando le dai contesto.

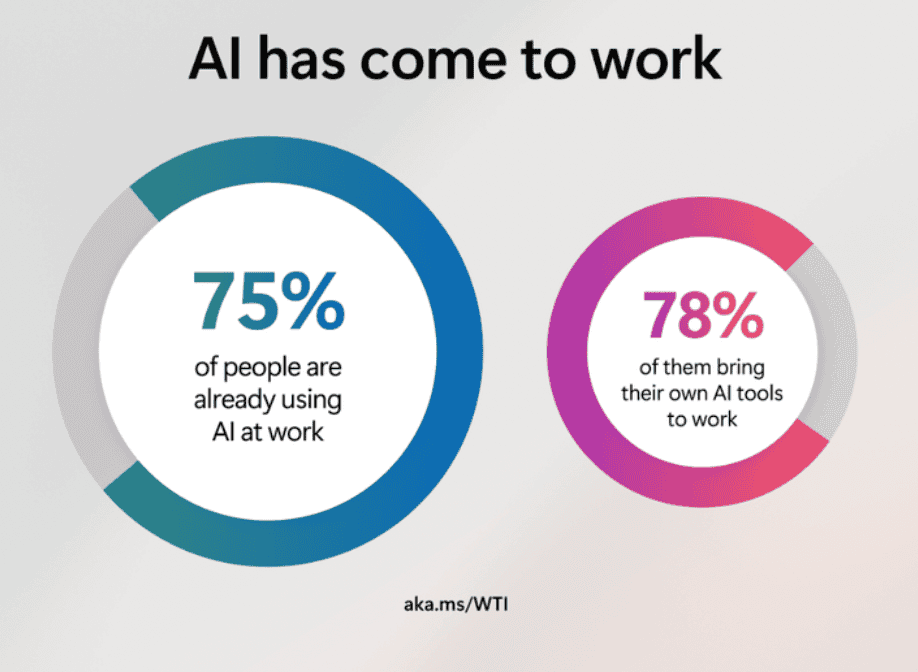

Negli ultimi due anni diverse analisi (da aziende di sicurezza, osservatori e report di produttività) convergono su un’idea semplice: l’adozione dell’AI in azienda è già “avvenuta” dal basso, spesso con strumenti consumer o non approvati. E dove c’è adozione spontanea, c’è anche condivisione spontanea di informazioni. Microsoft, ad esempio, citando il proprio Work Trend Index, riporta che una gran parte dei dipendenti usa AI al lavoro e molti portano strumenti personali (“bring your own AI tools”).

Il dato che conta: nei prompt finiscono dati sensibili (e più spesso di quanto pensi)

La prova empirica arriva soprattutto da chi osserva flussi reali con sistemi di DLP e sicurezza. Cyberhaven – in un’analisi molto citata – stimava già nel 2023 che una quota rilevante dei contenuti incollati in ChatGPT in contesto lavorativo rientrasse nella categoria “confidential”.

Più di recente, Harmonic Security (ripresa da Axios) ha misurato su larga scala che oltre il 4% dei prompt e più del 20% dei file caricati su tool genAI contenevano dati sensibili – con codice tra le tipologie più esposte.

Qui il punto interessante non è lo “scandalo”: è la dinamica. I contenuti sensibili non entrano nei prompt come “segreti aziendali” dichiarati. Entrano come contesto operativo: “riscrivi questa email al cliente”, “riassumi questo rapporto”, “ottimizza questa query”, “fammi una bozza di risposta legale”, “spiegami perché questa cosa nel team si blocca sempre”.

Perché l’AI diventa una radiografia dell’azienda (più che un rischio IT)

Il tema viene spesso ridotto a compliance e cyber risk. È corretto, ma incompleto. La cosa più importante – e più sottovalutata – è che i prompt descrivono l’azienda com’è, non come appare nei documenti ufficiali.

Nei prompt emergono tre strati di informazione:

1) Dati “hard”

Codice, credenziali, dati cliente, prezzi, contratti, informazioni sul budget, forecast, procedure interne. Axios segnala proprio l’effetto “upload”: l’AI embedded in strumenti SaaS e documentali incentiva il caricamento di file, e i controlli tradizionali possono fare fatica a intercettare tutto.

2) Processi reali

Cosa si fa davvero, dove si inceppa, quali workaround esistono, quali passaggi sono ridondanti. Qui l’AI diventa un acceleratore – e nel farlo si porta dietro l’intera mappa del processo.

3) Dinamiche sociali e organizzative

Questo è il livello più osservabile: i prompt diventano confessionali operativi. Il dipendente chiede come gestire un conflitto, come negoziare con un manager, come scrivere un messaggio “delicato”, come impostare un confronto con un collega. In pratica: l’AI viene usata come coach, mediatore, ghostwriter.

Se leggi questa cosa con lente strategica, capisci perché la “shadow AI” è un fenomeno strutturale. TechRadar, riprendendo dati di ricerca recente, descrive percentuali alte di uso di strumenti non approvati e di condivisione di informazioni sensibili – con un dettaglio inquietante: anche figure senior e executive partecipano al fenomeno.

Shadow AI: la causa vera è utilità, non malizia

Per capire cosa sta succedendo, serve togliere moralismo. La “shadow AI” nasce quasi sempre da una logica lineare: l’AI fa risparmiare tempo, migliora la scrittura, accelera analisi e sintesi, sblocca lavoro. Se l’azienda offre tool approvati che sembrano lenti, limitati o macchinosi, le persone scelgono alternative. Microsoft lo dice esplicitamente: i dipendenti non aspettano rollout ufficiali.

Questo significa che la governance efficace raramente parte da “divieti”. Parte da una domanda più concreta: qual è il flusso di lavoro che le persone stanno già usando con l’AI, e perché? Da lì costruisci policy, strumenti e formazione che reggono sul campo.

Il paradosso: l’azienda perde la propria “verità operativa”

C’è un effetto collaterale che vale un discussione da solo: il management riceve report filtrati, l’AI riceve la realtà grezza.

Se l’azienda non osserva l’uso reale dell’AI, succedono due cose insieme:

- aumenta l’esposizione (dati e file finiscono dove non dovrebbero)

- cresce una forma di “consulenza parallela” che intercetta problemi profondi prima dei canali ufficiali

In altre parole: i prompt diventano un termometro organizzativo. E questo termometro, oggi, è spesso fuori dalla stanza.

Cosa dovrebbe fare un’azienda pragmatica

Tre scelte, in sequenza, che distinguono chi governa il fenomeno da chi lo subisce:

1) Offrire un’alternativa “approved” che sia davvero usabile

Se l’esperienza è peggiore del tool consumer, perdi. Microsoft spinge proprio sull’idea di portare AI chat “per tutti” con protezioni commerciali e governance.

2) Mettere guardrail leggeri ma reali

Classificazione dati chiara, redazione automatica dove possibile, log e auditing, training pratico su “cosa incollare e cosa no”. Molte analisi di settore insistono sul bisogno di visibilità su prompt e allegati per ridurre i blind spot.

3) Usare l’osservazione come vantaggio competitivo

Senza leggere contenuti sensibili, si possono analizzare pattern aggregati – quali funzioni usano l’AI, per cosa, dove si concentrano rischi, quali processi chiedono automazione. È un modo pulito per far emergere inefficienze e bisogni reali.