Un progetto personale, qualche riga di Python, e un risultato che sta facendo il giro della comunità AI. Si chiama nano‑vLLM, ed è un’implementazione minimalista del celebre motore di inferenza vLLM, scritta interamente da zero, con meno di 1.200 righe di codice.

Sembra un esercizio da laboratorio, ma funziona. E in certi scenari offline va addirittura più veloce dell’originale.

Cos’è davvero nano‑vLLM

Nano‑vLLM è stato creato da Yu Xingkai, ricercatore di DeepSeek, come side project. L’idea non era costruire un prodotto competitivo, ma offrire un punto di partenza chiaro e modificabile per chi vuole capire come funziona l’inferenza nei modelli linguistici di grandi dimensioni.

Un approccio educativo, pulito, trasparente. Eppure, testato su una GPU RTX 4070, ha raggiunto 1.434 token al secondo, contro i 1.362 di vLLM. Tutto questo senza batching dinamico, senza orchestratori complessi, senza magie nascoste.

Ne parla anche Hugging Face, che ha pubblicato un’analisi dettagliata del progetto, definendolo “una risorsa didattica eccellente per chi vuole imparare i fondamenti dell’inferenza LLM”.

Perché c’entra Arduino

Il paragone con Arduino non è casuale. Come la famosa scheda ha permesso a migliaia di persone di costruire da sé dispositivi elettronici, nano‑vLLM consente a studenti, ricercatori e sviluppatori curiosi di costruirsi un motore LLM funzionante e comprensibile.

Il codice è scritto in Python puro, senza astrazioni inutili, e implementa tutti i passaggi fondamentali: gestione della cache, sampling, parallelismo, ottimizzazione con torch.compile() e CUDA Graphs. Niente wizard, niente layer opachi. Solo quello che serve per capire.

Come si installa (e cosa serve)

Nano‑vLLM non si scarica con un click, ma è sorprendentemente semplice da avviare.

Basta eseguire questo comando:

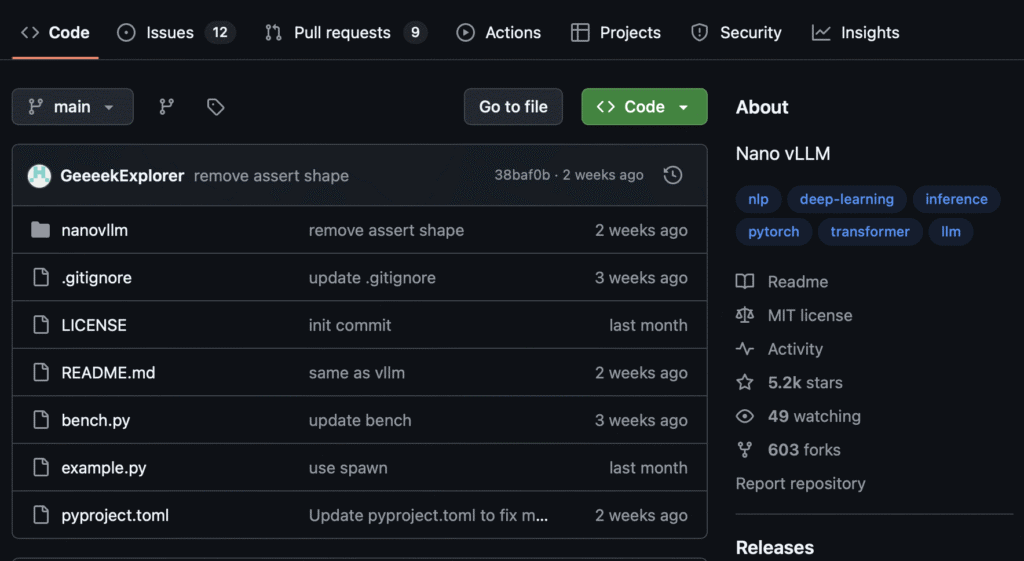

pip install git+https://github.com/GeeeekExplorer/nano-vllm.git

Il progetto è pensato per funzionare con modelli compatibili Hugging Face (ad esempio Qwen‑0.5B). Serve una GPU, ma anche un laptop con 8 GB può bastare per piccoli test. Dopo aver scaricato il modello, bastano poche righe in Python per farlo generare output. Il tutto senza dipendenze ingombranti, configurazioni complesse o ambienti chiusi.

Cosa ci fai, oggi

Nano‑vLLM non è pronto per la produzione, e non lo vuole essere. Non gestisce richieste concorrenti, non ha uno scheduler per il batching, non offre streaming token-by-token. Ma è perfetto per chi vuole prototipare, fare esperimenti, oppure capire davvero come si costruisce un sistema di inferenza moderno.

Lo puoi trovare su GitHub, ed è un modo concreto per imparare (anche sbagliando) i principi architetturali che muovono i grandi modelli linguistici.

Perché potrebbe diventare importante

Nel mondo degli LLM, tutto è diventato gigantesco, astratto, quasi mistico. Nano‑vLLM va nella direzione opposta: è leggibile, ispezionabile, smontabile. E in questo momento storico, in cui tanti sviluppatori vogliono capire prima di affidarsi a soluzioni chiuse, un progetto così ha un valore strategico.

Leggi anche NVIDIA Jetson Orin Nano Super e il futuro dell’IA compatta

Il codice che fa scuola

In un momento in cui i grandi modelli sembrano riservati solo a big tech e cloud provider, nano‑vLLM rimette al centro la figura dello sviluppatore curioso.

Non è una piattaforma, non è una scorciatoia, ma un banco di prova per imparare davvero.

E come successe con Arduino, potrebbe ispirare una generazione di maker dell’AI.