Hugging Face è una piattaforma leader nell’intelligenza artificiale che si concentra soprattutto sul Natural Language Processing (NLP), ma si estende anche ad altri ambiti dell’IA. Inizialmente conosciuta come una semplice app per chatbot, oggi Hugging Face offre un intero ecosistema open source: ospita migliaia di modelli pre-addestrati, dataset e strumenti che permettono a chiunque di sperimentare, sviluppare e distribuire applicazioni AI. Con librerie come Transformers, Datasets e Tokenizers, la piattaforma rende più accessibili tecniche avanzate, consentendo anche a chi ha poca esperienza di iniziare a lavorare con l’IA.

Quale problema risolve

Lo sviluppo e l’implementazione di modelli di intelligenza artificiale richiedono spesso una grande quantità di dati, competenze tecniche e risorse hardware. Hugging Face risolve questi problemi fornendo:

- Accesso immediato a modelli di ultima generazione: grazie al vasto Model Hub, è possibile scaricare modelli come BERT, GPT e RoBERTa, senza doverli addestrare da zero.

- Semplificazione del flusso di lavoro: le sue librerie gestiscono attività complesse come la tokenizzazione (cioè la conversione del testo in numeri che i modelli possono elaborare), il pre-processing dei dati e l’inferenza (cioè l’uso del modello per fare previsioni su nuovi dati).

- Collaborazione e condivisione: gli utenti possono caricare e condividere i propri modelli e dataset in un repository (una specie di “libreria” online) che tutti possono consultare e migliorare.

Caratteristiche principali

Hugging Face offre numerosi strumenti e funzionalità:

- Transformers Library: Una raccolta di modelli pre-addestrati per il NLP (e anche per altre applicazioni) che possono essere facilmente fine-tunati (personalizzati) per specifiche necessità.

- Datasets Library: Un’ampia collezione di dataset, ovvero insiemi di dati strutturati, necessari per addestrare e testare i modelli.

- Tokenizers Library: Strumenti che trasformano il testo in “token” (unità di testo come parole o parti di parole), un passaggio fondamentale prima di inviare il testo al modello.

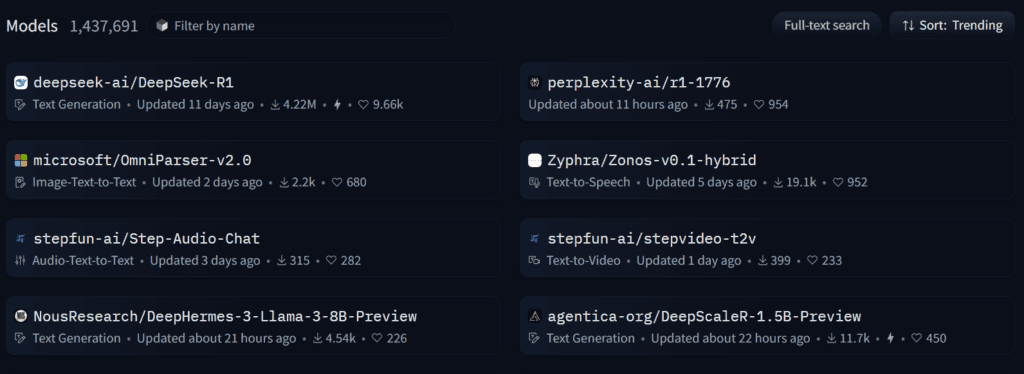

- Model Hub e Repository: Un repository online dove trovare, scaricare e caricare modelli. Un “repository” è un archivio digitale dove il codice, i modelli e la documentazione vengono conservati e condivisi.

- Inference API: Un servizio che consente di utilizzare i modelli in produzione per ottenere previsioni (o inferenze) senza dover gestire l’infrastruttura tecnica sottostante.

- Spaces: Uno spazio interattivo per demo e applicazioni dove è possibile vedere in azione i modelli e testarne le capacità direttamente dal sito.

- AutoTrain e strumenti no-code: Funzionalità per eseguire il fine-tuning dei modelli senza dover scrivere codice complesso, ideali per chi vuole sperimentare rapidamente.

A chi è destinato

Hugging Face è pensato per un pubblico molto variegato:

- Per chi è agli inizi: La piattaforma è stata progettata per essere accessibile anche a chi non ha una profonda esperienza tecnica. Con interfacce intuitive, guide passo-passo e la possibilità di utilizzare modelli direttamente dal sito (senza installare nulla), è ideale per chi vuole avvicinarsi al mondo dell’IA.

- Per sviluppatori e ricercatori: Offre strumenti avanzati per chi desidera creare, personalizzare e distribuire modelli AI.

- Per chi vuole addentrarsi nel mondo dell’IA in maniera avanzata: Se sei interessato ad approfondire le tecniche più avanzate (come il fine-tuning personalizzato, l’ottimizzazione dell’inferenza e l’uso di hardware specializzato), Hugging Face mette a disposizione API, strumenti per l’addestramento e opzioni di deploy su cloud o in locale.

- Per aziende e professionisti: Che cercano soluzioni scalabili, sicure e personalizzabili per integrare l’IA nei loro processi e prodotti.

Costi

Hugging Face adotta un modello di business freemium:

- Livello gratuito: Offre accesso a migliaia di modelli e dataset, ideale per sperimentazione, progetti personali e studi.

- Account Pro: A partire da circa 9 $/mese, sbloccando funzionalità avanzate come un maggiore throughput nell’Inference API, accesso prioritario a risorse hardware (es. ZeroGPU) e strumenti di collaborazione avanzata.

- Soluzioni Enterprise: Con prezzi a partire da circa 20 $/utente/mese, pensate per organizzazioni che necessitano di controlli di sicurezza, gestione avanzata degli accessi, audit log e supporto dedicato.

- Costi hardware a consumo: Se usi le funzionalità per il deploy (come Spaces o Inference Endpoints), i costi variano in base al tipo di hardware (CPU, GPU, acceleratori) e all’utilizzo, con tariffe che possono partire da 0 $/ora fino a cifre più elevate per configurazioni avanzate.

Installazione

Per iniziare a utilizzare Hugging Face, hai diverse opzioni:

Utilizzo tramite sito web

Se non vuoi installare nulla in locale o non sei uno sviluppatore avanzato, puoi usare il sito di Hugging Face:

- Model Hub e Spaces: Naviga sul sito huggingface.co per cercare modelli, provarli in demo interattive (Spaces) e persino eseguire inferenze direttamente dal browser.

- Inference API: Utilizza l’Inference API per integrare modelli nelle tue applicazioni senza dover gestire l’infrastruttura tecnica.

Installazione tramite librerie (per sviluppatori e chi vuole lavorare in locale)

- Creare un ambiente virtuale (consigliato):

python -m venv .env source .env/bin/activate # Su Linux/MacOS .env\Scripts\activate # Su Windows - Installare le librerie principali:

pip install transformers datasets tokenizers huggingface_hub - Autenticarsi (opzionale):

Se vuoi caricare modelli sul Model Hub o accedere a modelli privati:from huggingface_hub import notebook_login notebook_login() # Segui le istruzioni sullo schermo

Spiegazione di alcuni concetti chiave

- Inferenza: È il processo con cui un modello AI prende dei dati di input (ad esempio, una frase) e produce un output (ad esempio, una previsione o una traduzione). È come “chiedere” al modello di fare qualcosa in base a quanto ha imparato durante l’addestramento.

- Repository: È un archivio digitale dove vengono conservati e gestiti i modelli, il codice e la documentazione. Su Hugging Face, ogni modello ha il suo repository sul Model Hub, dove puoi scaricare il modello o caricare aggiornamenti.

- Tokenizzazione: È il processo di suddivisione del testo in unità più piccole (token) che il modello può comprendere. I token possono essere parole intere o parti di esse.

- Fine-tuning: È il processo di personalizzazione di un modello pre-addestrato su un dataset specifico, per adattarlo meglio a compiti particolari o a un dominio specifico.

- Inference API: Un servizio che permette di utilizzare i modelli AI in tempo reale, ottenendo previsioni senza dover installare o gestire il modello in locale.

Conclusioni

Hugging Face è una piattaforma completa che rende l’IA accessibile a tutti, dal principiante che si avvicina per la prima volta al NLP fino al ricercatore esperto che vuole sperimentare tecniche avanzate. Grazie alle sue librerie open source, al Model Hub, all’Inference API e agli Spaces, offre soluzioni flessibili per sviluppare, condividere e distribuire modelli AI. Che tu preferisca installare le librerie localmente o utilizzare il sito per eseguire modelli in demo interattive, Hugging Face mette a disposizione gli strumenti necessari per innovare nel campo dell’IA, controllando costi, risorse e sicurezza.

Scopri anche lo strumento Automatic1111

FAQ

Cos’è Hugging Face?

È una piattaforma open source per il machine learning e il NLP, che offre modelli, dataset e strumenti per la collaborazione e la distribuzione di soluzioni AI.

Quali problemi risolve?

Semplifica lo sviluppo di modelli AI, riducendo la complessità di addestramento e deploy, e favorisce la collaborazione tramite repository e comunità open source.

Chi può utilizzare Hugging Face?

È adatto sia ai principianti che vogliono iniziare a esplorare il mondo dell’IA, sia a sviluppatori, ricercatori e aziende che necessitano di soluzioni avanzate e personalizzate.

Quanto costa?

Esiste una versione gratuita per sperimentazioni, un account Pro a partire da circa 9 $/mese e soluzioni Enterprise per esigenze avanzate, con costi hardware variabili a consumo.

Come posso iniziare?

Puoi installare le librerie tramite pip in un ambiente virtuale oppure utilizzare direttamente il sito di Hugging Face per accedere al Model Hub, provare demo interattive (Spaces) e utilizzare l’Inference API.

Cosa significa “inferenza”?

È il processo in cui un modello AI elabora nuovi dati per generare una previsione o un output, ad esempio tradurre un testo o classificare una frase.

Cos’è un repository?

È un archivio online dove vengono conservati i modelli, il codice e la documentazione; su Hugging Face, ogni modello ha il proprio repository accessibile e aggiornabile dalla community.