Almawave ha presentato Velvet, una famiglia di Large Language Models (LLM) interamente sviluppati in Italia, con un focus su sostenibilità, efficienza e rispetto del quadro normativo europeo. L’intelligenza artificiale Velvet si distingue per essere open source, multilingua e progettata per adattarsi a molteplici settori verticali, tra cui Sanità, Finanza, Mobilità, Sicurezza e Pubblica Amministrazione. Ma come si posiziona rispetto ai giganti dell’IA generativa come GPT-4, Claude e Llama?

Caratteristiche tecniche di Velvet

Almawave ha rilasciato due modelli della famiglia Velvet:

-

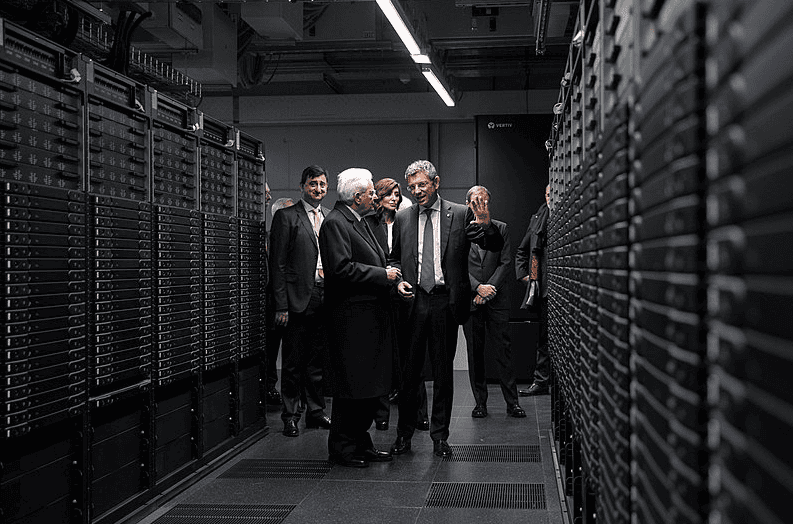

Velvet 14B: un modello con 14 miliardi di parametri, addestrato su 6 lingue (italiano, tedesco, spagnolo, francese, portoghese e inglese). Ha un vocabolario di 127 mila parole e una finestra di contesto da 128 mila token, rendendolo adatto a gestire documenti complessi. Il training è avvenuto sul supercomputer Leonardo di Cineca, con oltre 4.000 miliardi di token.

- Velvet 2B: una versione più leggera con 2 miliardi di parametri, focalizzata su italiano e inglese. Ha una finestra di contesto da 32 mila token e condivide lo stesso vocabolario del modello maggiore.

Entrambi i modelli sono rilasciati in versione Instruct e Open Source, rendendoli trasparenti e modificabili dalla community.

Quirinale.it

Punti di forza di Velvet

- Sostenibilità energetica: Almawave ha progettato Velvet per essere leggero e a basso consumo, riducendo l’impatto ambientale e i costi operativi.

- Focalizzazione sulla lingua italiana: rispetto ad altri modelli internazionali, Velvet si distingue per una migliore comprensione delle sfumature linguistiche italiane.

- Rispetto del quadro normativo europeo: conforme all’AI Act, utilizza tecniche avanzate di data lineage per ridurre i bias e garantire la privacy.

- Privacy Association Editing (PAE): un algoritmo proprietario che permette di eliminare informazioni sensibili direttamente dal modello, senza bisogno di riaddestramento.

- Versatilità: disponibile in cloud, on-premise e on-the-edge, si integra con piattaforme come AWS, Oracle, Microsoft, Dell e IBM.

Velvet vs. altri modelli di IA

| Modello | Parametri | Finestra di contesto | Lingue | Caratteristiche distintive |

|---|---|---|---|---|

| Velvet 14B | 14B | 128K | 6 | Basso consumo, ottimizzato per l’italiano, open source |

| Velvet 2B | 2B | 32K | 2 | Versione leggera, open source, italiano/inglese |

| GPT-4 | 1.76T | 32K (GPT-4-turbo) | 26+ | Modello proprietario, prestazioni elevate |

| Claude 2 | 100B+ | 200K | Inglese | Focus su sicurezza e trasparenza |

| Llama 2 | 7B, 13B, 65B | 4K-32K | Multilingua | Open source, supportato da Meta |

Velvet si posiziona come un modello di fascia intermedia, tra i Llama 2 di Meta e GPT-4 di OpenAI. Il numero di parametri è inferiore rispetto ai modelli più avanzati, ma ciò consente maggiore efficienza energetica e facilità di implementazione.

Applicazioni pratiche di Velvet

Grazie alla sua struttura, Velvet può essere impiegato in diversi settori:

- Sanità: elaborazione di cartelle cliniche e supporto alla diagnosi.

- Pubblica Amministrazione: automazione dei servizi al cittadino.

- Sicurezza: analisi e gestione di dati critici.

- Finanza: elaborazione di grandi volumi di dati per il risk management.

- Mobilità: ottimizzazione dei flussi di trasporto.

Leggi anche: Intelligenza Artificiale nel 2025

Conclusione

Velvet rappresenta un passo importante per l’intelligenza artificiale generativa in Italia, combinando efficienza, sostenibilità e specializzazione linguistica. Sebbene non sia un diretto concorrente di modelli come GPT-4, offre un’alternativa più leggera e adattabile, con un occhio di riguardo per la regolamentazione europea e la privacy.